HADOOP NEDİR?

Hadoop, commodity hardware adı verilen klasik sunucularda büyük verileri işlemek amacıyla kullanılan bir sistemdir. Temel olarak yazılımı dağıtık dosya

sistemi olarak tanımlayabiliriz. Bu dağıtık dosya sistemi HDFS yani Hadoop Distributed File System olarak adlandırılıyor.

Hadoop yazılımı bize HDFS ile Mapreduce fonksiyonlarını birleştirerek Java ile açık kaynak kodlu olarak geliştirilmiş güncel bir kütüphane

sunuyor. Hadoop nedir sorusuna verilebilecek en basit yanıt ise sunucuların büyük veri işleme amacıyla kullandıkları

sistemdir.

Big Data Nedir?

Hadoop sistemi baz alındığında en sık görülen terimlerin başında big data geliyor. Big data nedir ya da Türkçe karşılığıyla büyük veri nedir soruları çoğunlukla merak edilenler arasında yer alıyor.

Big data temel olarak büyük veri olarak çevrilmiş olsa da aslında boyutsal bir büyüklüğü sembolize etmemektedir. Aslen programcılar tarafından dev veri

olarak anılmaktadır. Burada ki büyük ve dev tabirleri klasik yöntemler kullanılarak işlenemeyen verileri tanımlıyor.

Big data somut olarak bakıldığı zaman hayatımızın her alanını kapsayabiliyor. Örneğin bir otomobil firması sensörler sayesinde sürücülerin

sürüş istatistiklerini toplamaya başladı. Bunun gibi medikal veriler, üretim verileri, teknolojik gelişmeler toplandığında big data oluşuyor.

Peki bu kadar verinin nerede tutulduğunu hiç düşündünüz mü? Evimizde var olan disk sürücüleri terrabyte boyutlarında bazen bize yetmeyebiliyor. Büyük veri

için bahsedeceğimiz boyutlar petabyte, exabyte ya da zettabyte düzeylerinde olabiliyor. Önümüzdeki 5 sene içinde dünya genelinde depolanan big data

boyutunun 35 zettabyte düzeyinde olması bekleniyor.

Big data nasıl

işleniyor

sorusu herkesin merak ettiği bir kavram. Bu konuyu klasik donanımsal yöntemlerle çözmek milyon dolarlık yatırımlara sebep olabilir. Çünkü işlenecek veri

gerçekten çok fazla. Ayrıca klasik yöntemlerle aynı performansı almak çok zor diyebiliriz.

Örneğin Google arama motorundan yaptığımız aramaların sonuçları saniyeler içerisinde karşımızda duruyor. Bunu klasik bir yöntemle yapsaydı belki aradığımız

bir habere 2-3 gün sonra ulaşabilirdik. Bu anlamda Apache projesi olarak adlandırılan Lucene, Solr, Hadoop, HBase sistemleri big data

işlemek için yaratılmış yazılımlar olarak dikkat çekiyor.

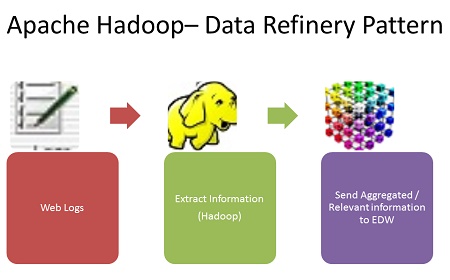

Apache Hadoop Nedir?

Apache Hadoop nedir

konusunda kısaca büyük veri işleme sistemi diyebiliriz. Apache projesi olarak 2011 yılında başlayan geliştirmeler bu alanda büyük bir başarı sağlamıştır.

Apache Hadoop, açık kaynak kodlu olarak Java için geliştirilmiş büyük veri kümeleri işleme aracıdır.

Apache Hadoop iki ana bölüme ayrılarak incelenebilir. Depolama bölümü olarak dağıtık veri sistemi olarak bilinen HDFS ve işleme modülü olarak MapReduce

kullanılmaktadır.

Apache Hadoop sayesinde büyük veri işlemeleri kısa sürede halledilebilir. Bu harika bir mimarisi olduğundan kaynaklanan bir özelliktir. Hadoop kurulumu

sayesinde Big data sunucu içinde bilgisayar kümelerince bölüştürülür. Dolayısıyla yük azalacağı gibi işlem süreside kısalır.

Apache Hadoop

teknik anlamda bu bileşenlerle işlemektedir.

-

Hadoop Common, dev bir kütüphane ve yardımcı Hadoop modüllerinden oluşan büyük veri işlemesine yardımcı kaynaklar

-

HDFS, büyük veri kapsamına giren veri yığınlarını işlerken veri kümeleri oluşturmak için kullanılan dağıtılmış veri sistemi

-

Hadoop Yarn, işlenecek verilerin üzerinde kaynak yönetimi, uygulama kullanımı ve kişisel ayarlamalar için veri depolama adına yaratılmış olan

kaynak yönetim platformu

-

Hadoop MapReduce, büyük veri işlemeleri için kullanılan programlama sistemi

Hadoop MapReduce

Hadoop Mapraduce

büyük veri işlemek için ihtiyacımız olan demirbaşlardan birisidir. Temel anlamda Map ve Reduce bu sistemi oluşturmaktadır. Kullanacağımız depolanmış veriyi

filtreleyen map fonksiyonu ve işlediğimiz verilerin analizini sunan Reduce fonksiyonu birleştiğinde Hadoop MapReduce ortaya çıkmıştır.

Hadoop bu noktada Map ve Reduce ile gelişmiş bir sistem mimarisinde çalışmaktadır. İşlenecek olan verilerin oluşturduğu görevleri farklı kümelere dağıtarak

aynı anda daha hızlı işlenmesini sağlar. Ayrıca işlenen verilen sonuçlarının toplanması ve analiz edilmesi diğer vasıflarıdır.

Mapreduce nedir

sorusunu yanıtladığımıza göre birazda içeriğinden bahsetmekte fayda var. Genel bir tabirle ne kadar çok sistem yükü olursa işlem süresi ve işlem ağırlığı

artar. Ancak Mapreduce ile bunun tam tersi oluyor diyebiliriz.

Çünkü Hadoop Mapreduce işlem kümeleri üzerinden çalıştığı için ne kadar çok işlem yapılırsa o kadar çok veri kümesi oluyor. Haliyle

aslında daha fazla işlemle daha iyi sonuçlar elde etmek mümkün hale geliyor. JobTracker ve TaskTracker isminde iki farklı fonksiyondan bahsedebiliriz.

JobTracker, MapReduce üzerinde işlenecek olan veri kümelerinden sorumludur. Veri işleme esnasında oluşacak sorunlara yeniden başlatarak, sonlandırarak ya

da hata ayıklayarak çözümler sunar. TaskTracker ise JobTracker tarafından belirlenmiş verileri tamamlamak için iş parçacığı bekler. Dolayısıyla TaskTracker

verilen iş parçacığını tamamlayarak HDFS üzerinde bir dosya olarak bitirir.

Hadoop Dersleri

Hadoop dersleri

birçok özel kurum tarafından verilmektedir. Aynı zamanda internet üzerinde konuyla ilgili birçok dokümana ulaşmanız mümkün.

Hadoop eğitimi

aslında gelecekte daha sık karşılaşacağımızı varsayarsak oldukça faydalı olacaktır. Çünkü teknolojinin ilerlemesi ve sosyal medya devrimi ile birlikte dev

şirketler ellerinde tuttukları büyük istatistik verilerini işleme konusunda aynı sistemi kullanmaktadır. Hadoop eğitimi bu noktada gelecek

için güzel bir yatırım olabilir.

İnternet üzerinden makale ve tezler okuyarak, eğitim videoları izleyerek Hadoop, Hadoop Mapreduce, Big data yani büyük veri konularında bilgi sahibi

olabilirsiniz.

Hatta bilgi sahibi olmanın ötesine geçerek büyük veri işleme konusunda kendinizi geliştirerek büyük projelerde görev alabilirsiniz.